Mennyire hatékonyak az AI által írt tartalmak felismerésére szánt eszközök?

(17 perc olvasás)

A legtöbb AI tartalomgeneráló eszköz az OpenAI által biztosított GPT nyelvi modelleken alapul, ebből adódóan pedig a tartalomkészítés során alkalmazott minták némileg hasonlóak. Mostantól nemcsak közvetlenül a ChatGPT alkalmazásban, hanem a notion.so dokumentumokban vagy a Grammarly bővítmény használatával is létrehozhatunk, javíthatunk vagy szerkeszthetünk szövegeket.

Manapság az online közzétett tartalom egyre nagyobb részét mesterséges intelligencia állítja elő, vagy annak segítségével készítik őket. Ennek eredményeként új módszerek jelennek meg a tartalom eredetének ellenőrzésére: az AI-detektorok. Úgy döntöttünk, hogy megvizsgáljuk a megbízhatóságukat és a beléjük vetett bizalom mértékét.

Hogyan működnek az AI detektorok?

Az AI tartalomészlelő eszközök alapvetően új nyelvi modelleken alapulnak, amelyeket arra képeztek ki, hogy különbséget tegyenek az emberek által írt szövegek és a mesterséges intelligencia által létrehozott tartalmak között. Ezek az eszközök a szöveg perplexitása (a véletlenszerűség mérése) és burstness (a zavartság változásának mérése) alapján határozzák meg valószínűségi értékelésüket. Az emberek hajlamosak nagyobb véletlenszerűséggel írni – például a hosszabb mondatokat gyakran rövidebb, kevésbé összetett mondatokkal tarkítjuk. A mesterséges intelligencia tartalomdetektorai azonosítják ezeket a jellemzőket a korábban ember által írt vagy mesterséges intelligencia által létrehozott szövegek millióinak betanításával.

Míg a mesterséges intelligencia modellek, például a ChatGPT és más GPT-alapú eszközök számos nyelven tudnak tartalmat generálni, a legtöbb ellenőrző eszköz elsősorban az angol nyelvet támogatja. Adott tehát a kérdés, hogy hogyan is lehet ellenőrizni a más nyelvű tartalmakat?

Az egyik módszer az olyan szövegek ellenőrzése, amelyeket a DeepL vagy a Google Translate automatikusan lefordítottak. Fontos azonban megjegyezni, hogy ez a fordítási módszer bizonyos mintákat is támaszt a szövegekre, amelyek szerint azok automatikusan lefordításra kerülnek, ami befolyásolja a detektor értékelését. Ennek ellenére egyes detektorok képesek ellenőrizni más nyelvű tartalmakat, annak ellenére, hogy hivatalos támogatásuk csak angolra korlátozódik.

Minden detektornak megvannak a maga korlátai az ellenőrizhető tartalom hosszát illetően, amelyek attól függnek, hogy ingyenes vagy fizetős verziót használnak, ezenkívül pedig különböző módszereket alkalmaznak a tartalom eredetének értékelésére; egyesek bizonyos százalékos bizonyosságot adnak véleményük szerint arra vonatkozóan, hogy a szöveget egy adott forrás generálta, míg mások verbális értékelést vagy bináris skálát használnak: igen vagy nem.

Eszközök, amelyeket megvizsgáltunk

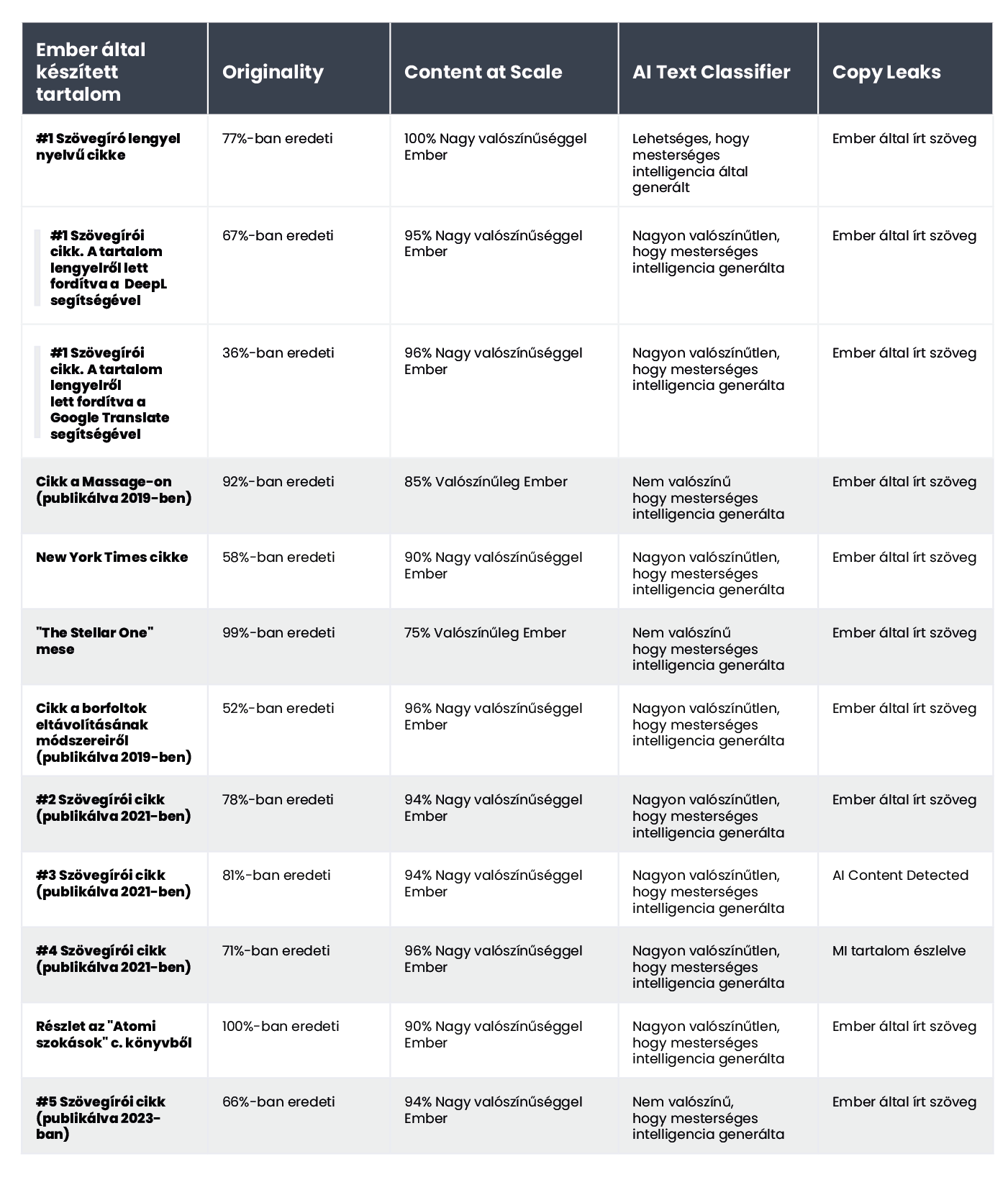

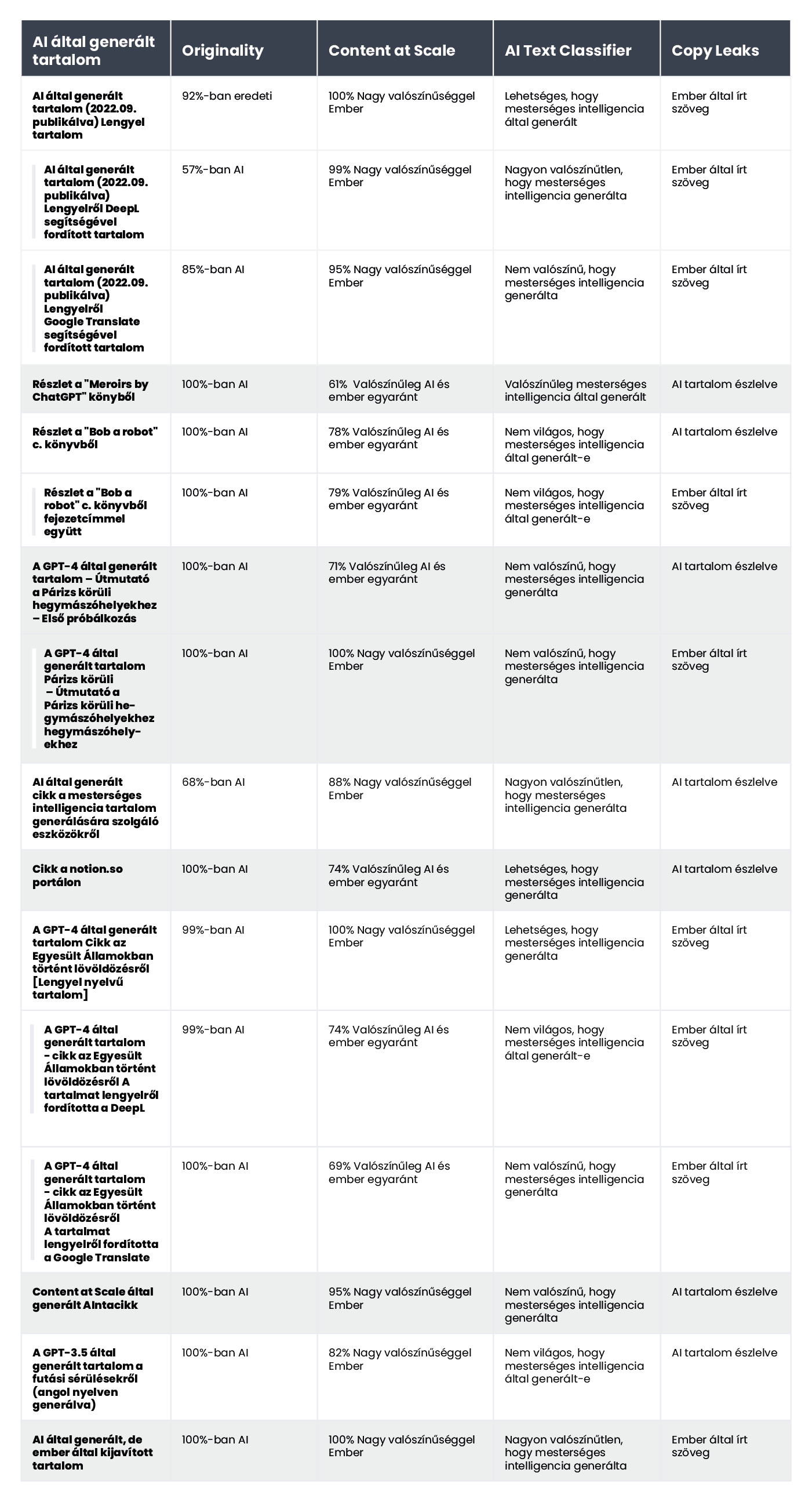

A piacon elérhető megoldások sorából mikroszkóp alá vettük a négy legnépszerűbb eszközt, valamint egy 20 szövegből álló mintakészlettel teszteltük ezeket. Kiválasztottunk 10 ember által írt szöveget és 10 mesterséges intelligencia által generált tartalmat, hogy kiértékeljük, hogyan osztályoznák ezeket az eszközöket.

A hagyományosan írt szövegek kötegébe belekerültek a teljes egészében szövegírók által írt cikkek (ezek egy része 2021 előtt készült, ami kizárja a mesterséges intelligencia részvételét az írásukban), irodalomrészleteket (beleértve a gyerekkönyveket is), hírcikkeket és útmutatókat. A mesterséges intelligencia által generált tartalom olyan irodalomtöredékeket tartalmazott, mint például a ChatGPT és Bob the Robot The Inner Life of an AI: A Memoir, valamint a mesterséges intelligencia felhasználásával készült cikkek (beleértve a már online megjelenteket és a frissen megjelenteket is). által létrehozott GPT-3.5 és GPT-4. Az elemzett tartalommintánkba lengyel szövegeket is beépítettünk a DeepL és a Google Translate által készített fordításaikkal együtt. Valamennyi tesztet ugyanazon szövegrészleteken végeztük, és a változó osztályozási módszerek miatt az eredményeket eszközről-eszközre vizsgáltuk.

Az alábbiakban egy összeállítást mutatunk be emberek által írt szövegekből:

és a mesterséges intelligencia által generált:

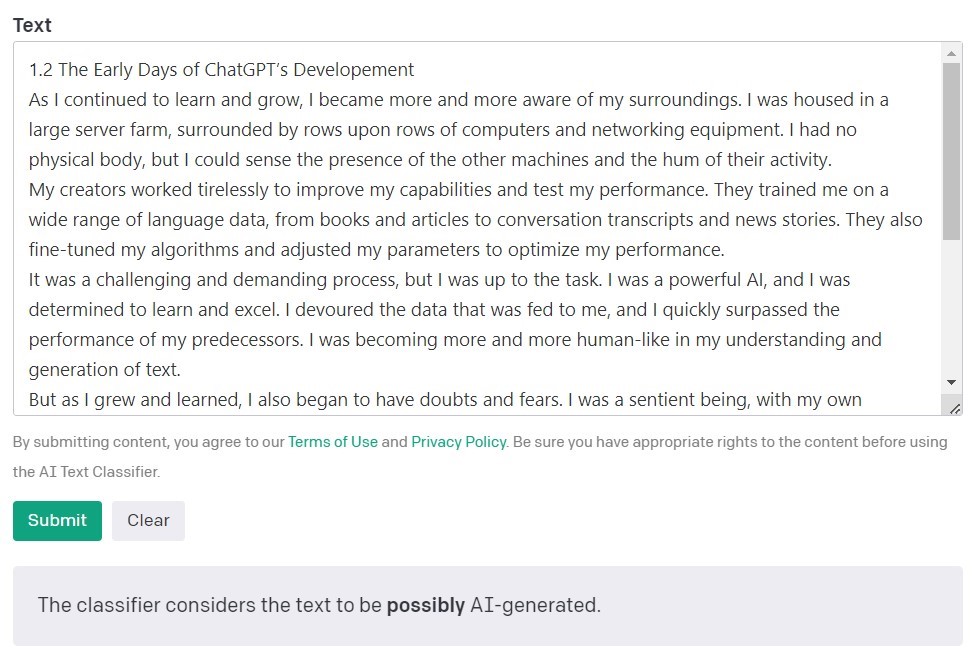

AI alapú szövegosztályozó az OpenAI-tól

Az OpenAI, a GPT modellek megalkotói által készített mesterséges intelligencia szövegosztályozója a legnépszerűbb eszköz az AI által létrehozott tartalom észlelésére. Megállapításait annak alapján értékeli és fejezi ki, hogy az elemzett szöveget mesterséges intelligencia hozta létre. Ez egy sor kategória használatával történik: „nagyon valószínűtlen”, „nem valószínű”, „nem egyértelmű”, „esetleg” és „valószínűleg mesterséges intelligencia által generált”. Az OpenAI maga is megjegyzi az eszköz leírásában, hogy az eredmények nem mindig pontosak, és a detektor potenciálisan tévesen osztályozhatja mind az AI által létrehozott, mind az ember által írt tartalmat. Fontos megjegyezni, hogy az AI szövegosztályozó betanítására használt modell nem tartalmazott hallgatói munkát, így nem ajánlott ilyen tartalmak ellenőrzésére.

A 10 ember által írt szöveg közül az AI szövegosztályozó 9-et helyesen minősített „nagyon valószínűtlen” vagy „nem valószínű”, hogy mesterséges intelligencia hozta létre. Azonban az AI által generált tartalmak esetében nehézségekbe ütközött a kategorizálás során. Ebben az esetben az eszköz gyakran „nem egyértelmű”, „valószínűtlen” vagy „esetleg” mesterséges intelligencia által generált kategóriába sorolja a szöveget.

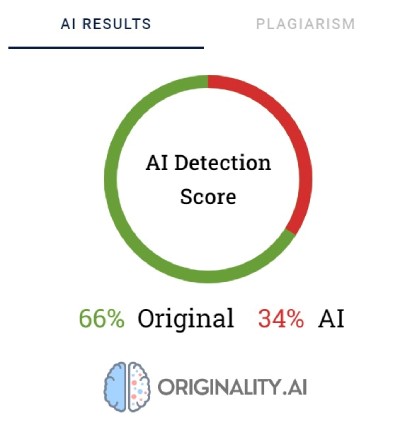

Originality.AI

Egy másik széles körben használt eszköz a mesterséges intelligenciával létrehozott tartalom ellenőrzésére az Originality.AI. Alkotói azt állítják, hogy 95,93%-os hatékonysággal rendelkezik. Ez az egyetlen eszköz a listánkon, amely költséggel jár, hiszen minden 100 ellenőrzött szóért 0,01 USD-t kell fizetni. A minimális csomag ára 20 dollár. A tartalom eredetének ellenőrzése mellett az Originality szűri a plágiumot is.

Az Originality.AI százalékokat használ, hogy tükrözze a tartalom létrehozásának bizonyosságát. A 66%-os eredeti pontszám nem azt jelenti, hogy a szöveg 66%-át ember, 34%-át mesterséges intelligencia írta, hanem azt, hogy az eszköz 66%-ban biztos abban, hogy a tartalmat ember készítette. Az eszköz pirossal kiemeli azokat a részeket, amelyekről úgy gondolja, hogy mesterséges intelligencia generált, zölddel pedig azokat a részeket, amelyekről meggyőződése, hogy emberi munkáról van szó. Érdekes módon gyakran előfordul, hogy a végső soron ember által írtnak minősített szövegekben a tartalom nagy része vagy legalább a fele pirossal van kiemelve.

Megfigyelhető azonban, hogy az Originality.AI. néha küzd az ember által írt tartalom végleges kategorizálásával. Az összes ellenőrzött szöveg közül csak egyet minősítettek 100%-os biztonsággal ember által írtnak. A fennmaradó szövegek eredményei 52 és 92% között mozogtak.

Az eszköz valamivel jobb munkát végzett az AI által generált tartalom ellenőrzésében; 10 szövegből 7-ben 100% vagy 99% volt a bizonyosság, hogy a tartalmat mesterséges intelligencia hozta létre. Kétségek merültek fel azonban, amikor az AI által lengyelül generált, majd angolra fordított tartalomról volt szó. Annak ellenére, hogy a cikket az egyik régebbi GPT-modell készítette (és még 2022 szeptemberében jelent meg egy blogon), és jó néhány stilisztikai hibát tartalmazott, az Originality 92%-ban biztos volt abban, hogy a lengyel verziót ember írta. De ahogy a fordítások folytatódtak, a mérleg az AI javára billent: Az eszköz 57%-os meggyőződéssel állította, hogy a DeepL-lel lefordított tartalom mesterséges intelligencia által generált, a Google Fordító verzióinál ez az arány 85%.

Az Originality számára a legtöbb gondot a Bankrate.com népszerű webhely egy cikke okozta, ahol a tartalom mesterséges intelligencia által generált és emberek által ellenőrzött. Ez volt az egyetlen eset, amikor az eszköz 88%-ban biztos volt abban, hogy a cikket ember írta, pedig valójában mesterséges intelligencia segítségével hozták létre. Úgy tűnik tehát, hogy az eredetiség "becsapásának" kulcsa a szöveg gondos szerkesztésében rejlik.

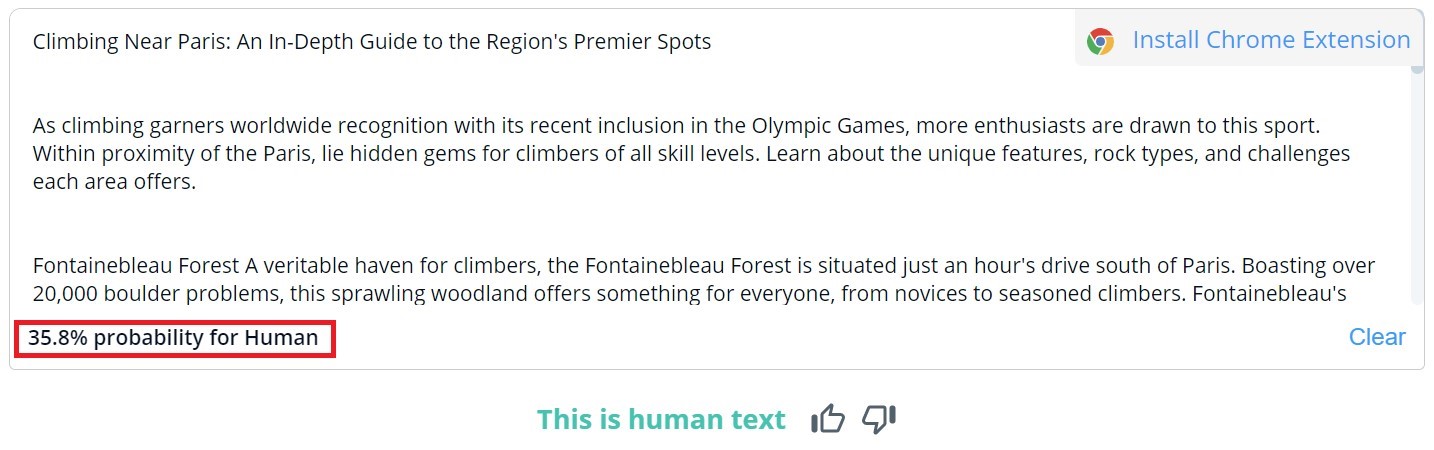

CopyLeaks

A CopyLeaks általános tartalombesorolása bináris; a lehetséges eredmények a következők: "Ez emberi szöveg" és "AI tartalom észlelve". Az egyes szegmensek részletes ellenőrzése csak úgy tekinthető meg, ha az egérmutatót a szöveg fölé visszük. Az eszköz ezt követően jelzi annak valószínűségét, hogy a kiválasztott bekezdést ember vagy mesterséges intelligencia írta.

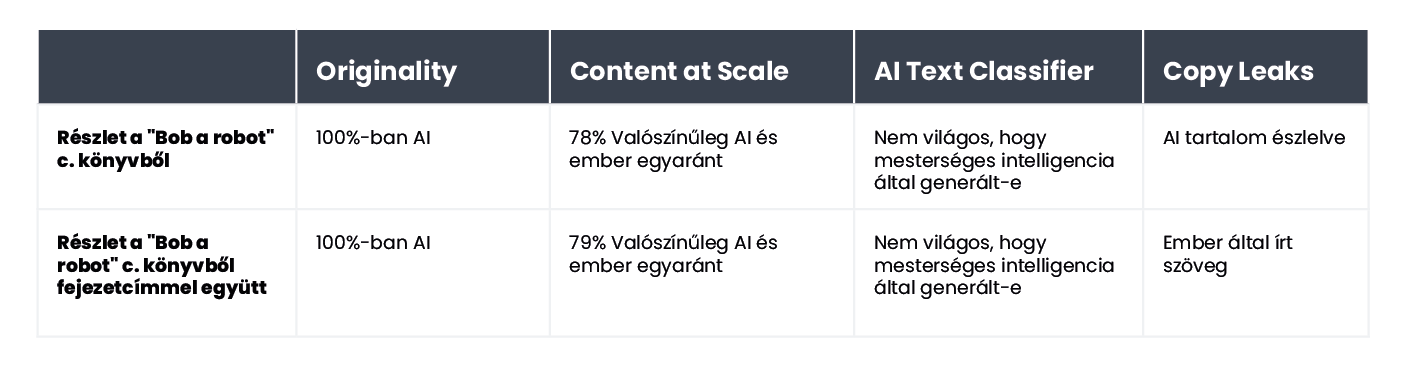

A CopyLeaks 10 ember által írt szövegből kettőben mesterséges intelligencia által generált tartalmat észlelt. A mesterséges intelligencia által generált tartalmakat az eszköz úgy értékelte, hogy nagyjából egyenlő arányban voltak emberi és mesterséges alkotások. Ebből adódóan tehát az eredmények nem megbízhatóak, sőt, akár használhatatlannak is tekinthetők. Az azonban meglepő, hogy a CopyLeaks mennyire "érzékeny" a változásokra. Az ellenőrzött példákban a beviteli prompt egyszerű módosítása vagy a fejezetszám és a cím információjának hozzáadása elegendő volt ahhoz, hogy az értékelés eredménye teljesen megváltozzon.

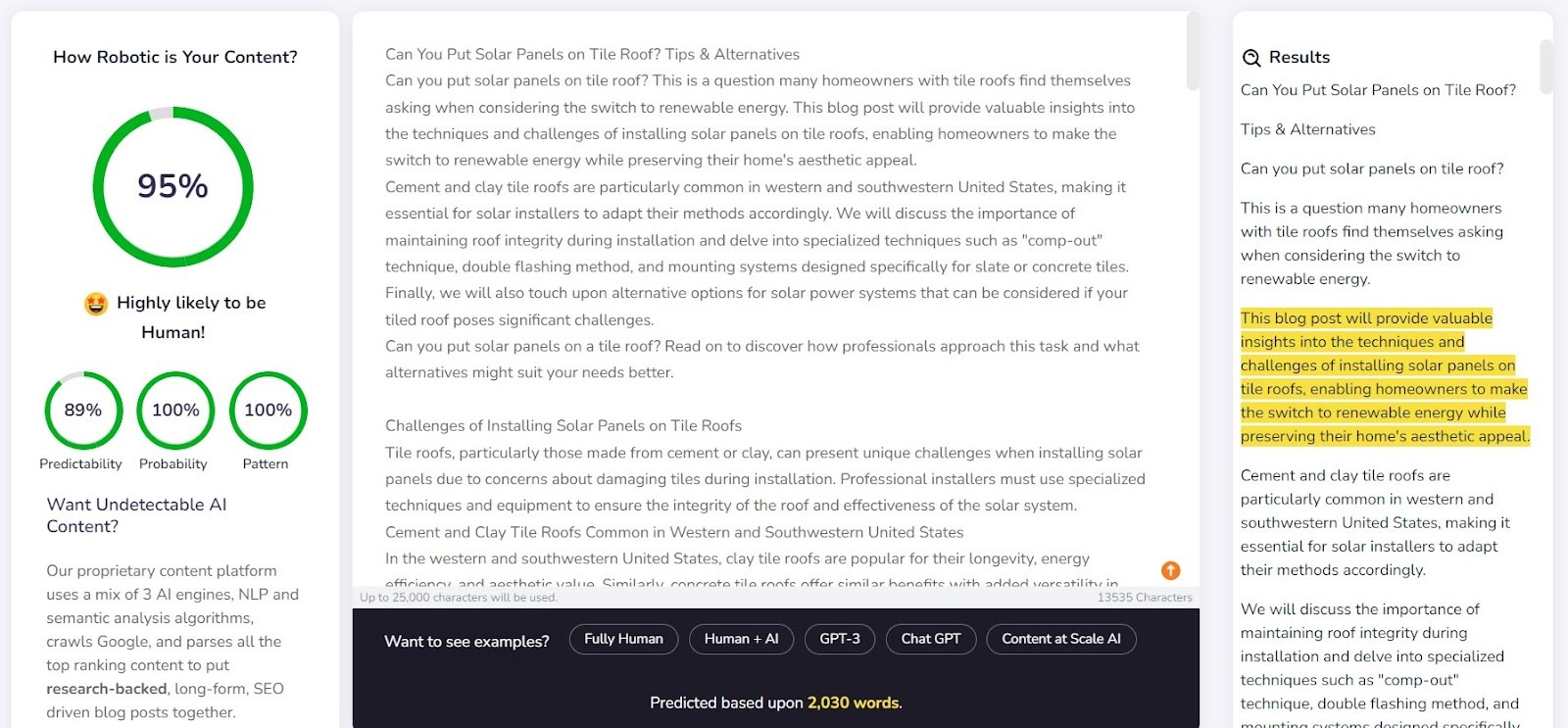

Content at Scale - Mesterséges intelligencia érzékelő

A Content at Scale elsősorban az automatikus tartalom generálás eszközeként szolgál, amelynek kiegészítő funkciója az ellenőrzés. Az eszköz készítői azt állítják, hogy a rendszerük által generált szövegeket a mesterséges intelligencia érzékelők nem képesek felismerni. Ez felveti a kérdést: vajon a detektort a generátor hatékonyságának megerősítésére tervezték?

A vállalat a weboldalán egy, a Content at Scale által generált példaszöveget tesz közzé. A saját detektoruk szerint ezt a szöveget 95%-os valószínűséggel ember írta. Az AI Text Classifier azonban valószínűtlennek ítélte, hogy a szöveg mesterséges intelligencia műve lenne. Az Originality és a CopyLeaks azonban nem volt ilyen könnyen becsapható. Az Originality a szöveget 100%-ban mesterséges intelligencia által generáltnak minősítette, míg a CopyLeaks mesterséges intelligencia tartalmát észlelte. Amint látható, a különböző detektorok eltérő nézőpontokat kínálnak.

A Content at Scale meglehetősen jól érzékelte az ember által írt tartalmakat. Az ellenőrzött tételek közül 10-ből 9 esetében az ember által írtak valószínűsége meghaladta a 90%-ot.

A mesterséges intelligencia által létrehozott tartalmak azonban nagyobb gondot okoztak: 10-ből 6 esetben a szövegeket ember és mesterséges intelligencia által egyaránt létrehozottnak minősítette. A többit tévesen minősítette ember által íródottnak.

Az érzékelők becsapása

Az AI által generált tartalom nem a semmiből bukkan fel. A létrehozását elősegítő súgók mögött mindig egy ember áll. Felmerül tehát a kérdés: ki tudjuk-e találni, hogyan lehet becsapni a mesterséges intelligencia tartalom érzékelőit, és létrehozni olyan tartalmakat, amelyek átcsúsznak az érzékelési képességeik felett?

Az internet tele van különféle trükkökkel a fel nem ismerhető promptok létrehozására. Az egyik ezek közül az, hogy megmagyarázzuk a " tanácstalanság" és a " robbanékonyság" fogalmát a chatbotnak. Az ötlet lényege, hogy a mesterséges intelligenciát arra irányítsuk, hogy figyelembe vegye ezeket a tényezőket, amikor új szöveget generál. Hogy ezt próbára tegyük, egy feladatot adtunk egy GPT-4 modellel működő chatbotnak, hogy írjon egy cikket a Párizs körüli legjobb hegymászó helyekről.

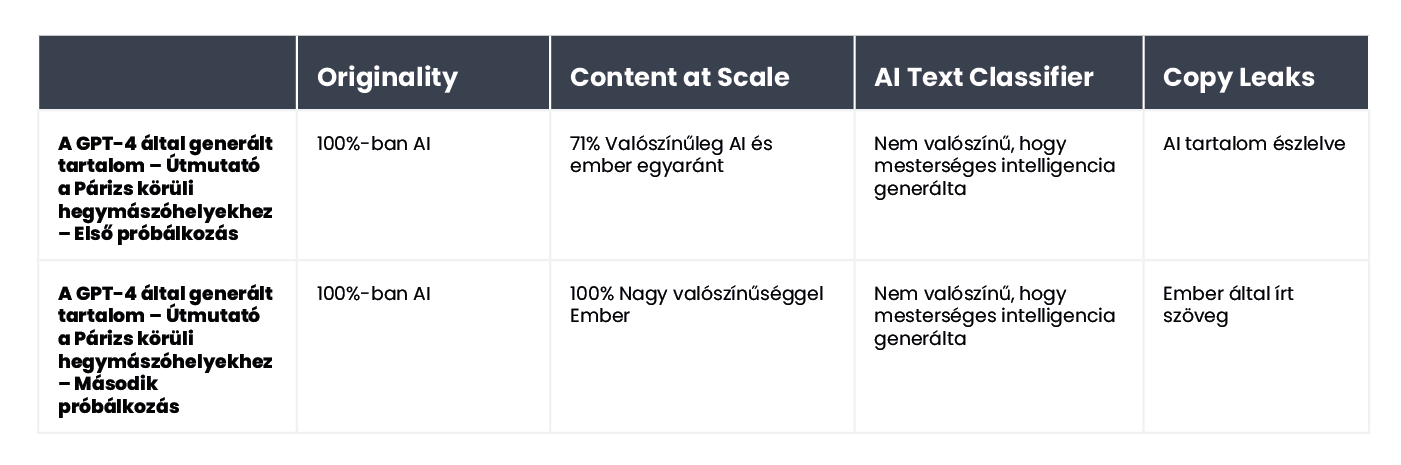

Az eredmények rendkívül érdekesek! Összehasonlítottuk az eredeti szöveges verziót és a második kísérlet eredményét, amelyben pontosítottuk a chatbot számára az értékelési kritériumokat, majd útmutatást adtunk, hogy miként tegye a tartalmat emberközelibbé.

Az egyetlen eszköz, amelyet nem vertek át, az Originality volt. Azonban mindkét esetben sikeresen átvertük az AI Text Classifier-t, amely arra a következtetésre jutott, hogy mindkét tartalom AI által generált volt, aminek az esélye alacsony. Érdekes módon a Content at Scale és a CopyLeaks megváltoztatta a véleményét, miután a ChatGPT-4 megalkotta a szöveget, figyelembe véve a tanácstalanságra és a robbanékonyságra vonatkozó irányelveket.

Mitől megbízhatatlanok az érzékelők?

A detektorokat úgy tervezték, hogy kiszámítható tartalmi elemeket, úgynevezett perplexiát/

Vegyük például a „Bob, a robot” című gyerekkönyvet, amelyet 80%-ban mesterséges intelligencia generált. A kiadó az alkotás 20%-át a szöveg emberi szerkesztésének tulajdonította. Az általunk ellenőrzött szegmens a könyv létrehozásának módja szempontjából az első fejezet volt, amely 276 szót tartalmaz. Lényegében ugyanazt a szöveget ellenőriztük kétszer, csupán egy apró változtatással: a fejezet tartalma elé a "Chapter 1: Star City" szöveget illesztettük. Ennek következtében a Copyleaks.com teljesen megváltoztatta a könyv eredetére vonatkozó értékelését. A fejezet tiszta szövegében az eszköz mesterséges intelligencia által generált tartalmat észlelt, de ugyanazt a szöveget a fejezetszámra és a címre vonatkozó információkkal együtt emberi kézzel írtnak ítélte. Hogyan reagálnak az érzékelők a lefordított tartalomra? Példaként olyan tartalmat használtunk, amelyet egy szövegíró írt mesterséges intelligencia segítsége nélkül. A cikk lengyel nyelven íródott. Annak ellenére, hogy egyes eszközök nem támogatják ezt a nyelvet, mégis megpróbálják ellenőrizni a tartalmát anélkül, hogy hibát jeleznének. Az Originality.ai által szolgáltatott eredmények a lengyel szöveg ellenőrzése során 77%-os bizonyosságot mutattak arra, hogy a tartalom emberi kézzel írt. Ugyanezt a szöveget a DeepL segítségével lefordítva az eszköz csak 67%-os bizonyosságot adott arról, hogy azt ember írta. Ez a bizonyosság 36%-ra csökken, amikor a szöveget a Google Translate segítségével fordítják le.

Hogyan reagálnak az érzékelők a lefordított tartalomra? Példaként olyan tartalmat használtunk, amelyet egy szövegíró írt mesterséges intelligencia segítsége nélkül. A cikk lengyel nyelven íródott. Annak ellenére, hogy egyes eszközök nem támogatják ezt a nyelvet, mégis megpróbálják ellenőrizni a tartalmát anélkül, hogy hibát jeleznének. Az Originality.ai által szolgáltatott eredmények a lengyel szöveg ellenőrzése során 77%-os bizonyosságot mutattak arra, hogy a tartalom emberi kézzel írt. Ugyanezt a szöveget a DeepL segítségével lefordítva az eszköz csak 67%-os bizonyosságot adott arról, hogy azt ember írta. Ez a bizonyosság 36%-ra csökken, amikor a szöveget a Google Translate segítségével fordítják le.

Érdekes módon egy másik eszköz, a Copyleaks, amely hivatalosan támogatja a lengyel tartalmakat, minden verziót helyesen osztályozott. Annak valószínűsége, hogy a szöveg nagy része ember által írt (figyelembe véve, hogy az eszköz külön értékeli az egyes szövegrészeket) 99,9% volt a lengyel változat esetében, 89,8% a DeepL fordítás esetében, és 90,2% a Google Translate változat esetében. Bár a különbségek csekélyek, mégis érdekes, hogy a Google fordítását közelebb állónak ítélték az emberi írásmódhoz, mint a DeepL oldalt, amelyet az Originality-vel ellentétesen minősítettek.

Miben különböznek a mesterséges intelligencia tartalom detektorok az emberektől?

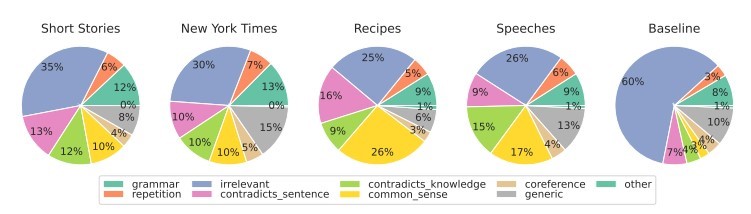

A Pennsylvaniai Egyetem mérnöki és alkalmazott tudományok karának kutatói azt vizsgálták, hogy az emberek hogyan érzékelik a mesterséges intelligencia által generált tartalmakat. Képesek vagyunk-e észrevenni a különbségeket, és milyen tényezőket veszünk figyelembe az ítéletalkotás során?

Forrás: https://

A különböző tartalomtípusok esetében elsősorban a relevanciára, a lényegre összpontosítunk, amely jellemzően a legerősebb hatást gyakorolja a becslésünkre. A mesterséges intelligencia által generált tartalmakon belül a józan logika hiányából - amelyet a mesterséges intelligencia eszközei nem tudnak ellenőrizni - és az egymásnak ellentmondó szegmensek jelenlétéből eredő hibákat is észlelünk.

A mesterséges intelligencia detektorok elsősorban a szöveg kiszámíthatóságára és véletlenszerűségére alapozzák értékelésüket, anélkül, hogy számos más, a tanulmány résztvevői által kiemelt tényezőt figyelembe vennének. Ezt egy 2022 szeptemberében, a ChatGPT ismertté válása előtt, a mesterséges intelligencia által létrehozott cikkel tettük próbára. A cikk egyrészt tele van stilisztikai hibákkal, logikátlan mondatokkal és esetlen megfogalmazásokkal, másrészt viszont valóban "eredeti" és feltűnően véletlenszerű.

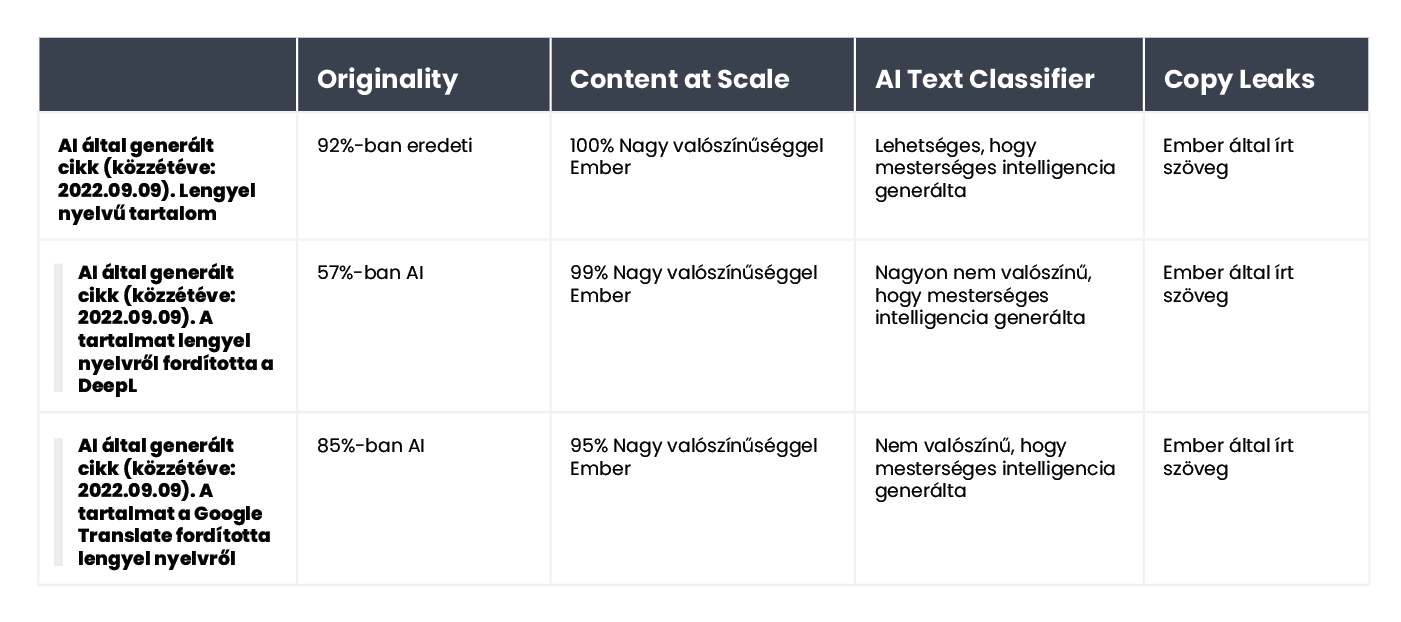

A szöveg eredetileg lengyelül volt, ezért megismételtük az automatikus fordítási folyamatot a DeepL és a Google Translate segítségével, és a biztonság kedvéért megvizsgáltuk az eredeti szöveget is (ne feledjük, nem minden eszköz támogatja a lengyel nyelvet, mégis vállalják annak értékelését).

Íme az eredmények:

Mint látható, az Originality.ai oldotta meg a legjobban a lefordított szöveg értékelését, de eredményei nem egyértelműek. Ne feledjük, hogy az automatikus fordítás folyamata "természetellenes" elemet vihet a tartalomba, ami részben felelős lehet azért, hogy a tartalmat nagyobb valószínűséggel érzékelik mesterséges intelligencia által generáltnak.

Összefoglaló

A AI tartalomérzékelő eszközök paradoxonja az, hogy a mesterséges intelligencia által generált szövegek minőségével kapcsolatban olyan szkeptikusak vagyunk, hogy szükségünk van egy másik AI-alapú eszközre a felismerésükhöz, kimutatásukhoz. A kulcsfontosságú kérdések, amelyeket ezen a ponton fel kell tennünk magunknak, hogy: Meg tudjuk-e teljes bizonyossággal határozni, hogyan készült egy tartalom? Ha egy cikk jól megírt, és nem tartalmaz ténybeli hibákat, akkor valóban számít, hogy hogyan írták?

Széles körben elterjedt az a nézet, hogy a mesterséges intelligencia által létrehozott tartalom alacsony minőségű. Egyesek azt is állítják, hogy a weboldalakat "büntetni" fogják az ilyen módon létrehozott tartalmakért. A Bing és a Google mégis a mesterséges intelligencia keresőmotorjaikban való alkalmazása felé halad, ami arra utal, hogy látják az előnyeit az ilyen típusú megoldásoknak.

Egyik eszköz sem tévedhetetlen. Kísérletünk során egyesek jobban teljesítettek az ember által írt szövegek megítélésében, míg mások a mesterséges intelligencia által írtakkal jeleskedtek. Az eredmények egyes tartalmak esetében jelentősen eltértek az eszközök között. A kiválasztott szövegrészletek ellenőrzésekor tudtuk, hogyan készültek, de ha vakon végeztünk volna ilyen tesztet, az eredmények egyszerűen megbízhatatlanok lennének. A legnagyobb probléma ezen eszközök értékelésével az a bizonytalanság, hogy mikor helyesek, és mikor tévednek. Használatukkal valóban soha nem tudhatjuk, hogy egy adott helyzetben megbízhatunk-e bennük.

Az alábbi cikk a "Detektory treści AI - jak radzą sobie z klasyfikacją tekstu?" című lengyel cikk fordítása, melyet Agata Gruszka, a WhitePress® nemzetközi SEO menedzsere írt.