Crawl budget Google - czym właściwie jest?

(11 min czytania)

Spis treści:

- Czym jest Crawl Budget Google?

- Co wpływa na Crawl Budget?

- Co to jest crawl rate limit?

- Jak sprawdzić crawl rate limit swojej strony?

- Crawl demand, czyli popyt na indeksację

- Dlaczego Crawl Budget jest ważny dla SEO strony?

- Jakie czynniki wpływają na budżet indeksowania Google?

- Podsumowanie

Czym jest Crawl Budget Google?

Na wstępie warto wrócić do zasady działania wyszukiwarki Google i jej fizycznych ograniczeń. Tworzenie tak dużej wirtualnej biblioteki - jaką niewątpliwie jest wyszukiwarka Google - wymaga ogromnych zasobów sprzętowych. Wspominałem o tym w artykule SEO a renderowanie JavaScript - jak sprawdzić oraz rozwiązać problemy w kontekście oczekiwania na wyrenderowanie plików JS. Aby zapewnić ciągłość działania wyszukiwarki, Google musi w sposób kontrolowany zarządzać czasem oraz ilością kroków Google Bota na stronach www. Właśnie ilość kroków, jakie może wykonać Google Bot na danej stronie możemy nazwać Crawl Budget.

Co wpływa na Crawl Budget?

Gdy wiemy już czym jest budżet crawlowania, warto zastanowić się skąd się on bierze i na podstawie jakich czynników jest on przypisywany. Oficjalnie Google podaje dwa parametry, które mają wpływ na określenie crawl budget’u:

- crawl rate limit.

- crawl demand.

Dopiero ocena tych dwóch parametrów umożliwia Google określenie, jak duży crawl budget warto przypisać do danego serwisu internetowego. Zacznijmy od omówienia pierwszego parametru, czyli crawl rate limit.

Co to jest crawl rate limit?

Jest to ustalany przez Google limit wydajności indeksowania. Określa on liczbę jednoczesnych połączeń równoległych, których może użyć Google Bot podczas indeksowania oraz akceptowalny czas oczekiwania między pobraniami danych.

Na to jak duży będzie crawl rate limit ma wpływ w znacznym stopniu techniczna kondycja serwisu. Wśród czynników, które najbardziej mają wpływ na w/

Zgodnie z informacjami prosto od Google wraz z szybszą reakcją witryny, rośnie jej crawl rate limit.

Gdy strona zaczyna pracować wolnej lub zaczynają się pojawiać błędy serwera - crawl rate limit jest ograniczany. Poprzez odpowiednią optymalizację, wybór dobrych i szybkich hostingów oraz monitorowanie błędów - mamy wpływ na w/

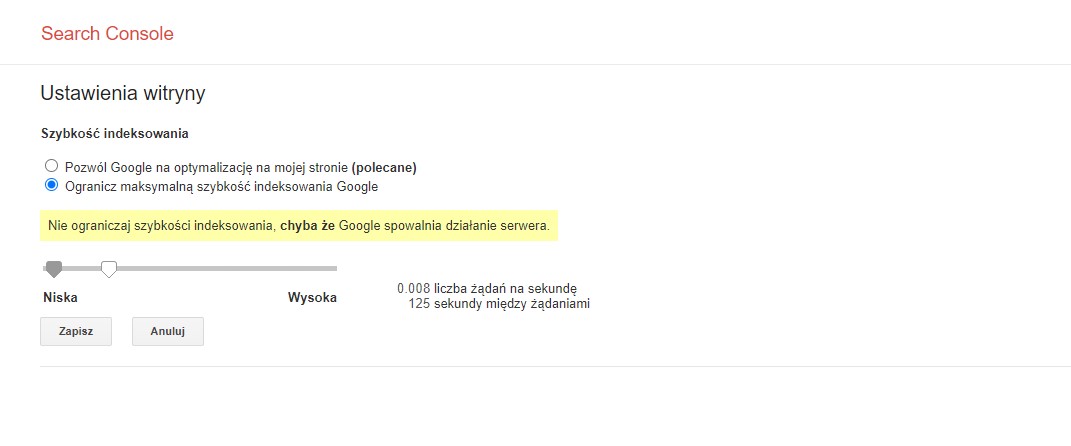

Ustawienia Google Search Console pod adresem: https://

Ustawienia Google Search Console pod adresem: https://

Warto jednak pamiętać, że używamy tej funkcji, gdy serwer nie radzi sobie z ilością wizyt Google, a zwiększenie szybkości ręczne na “wysoka”, nie zwiększa obecnej automatycznie przypisanej szybkości. W sytuacji, gdy serwer nie może podołać wizytom Google Bota - lepiej wybrać lepszy serwer, niż ograniczać szybkość indeksowania.

Jak sprawdzić crawl rate limit swojej strony?

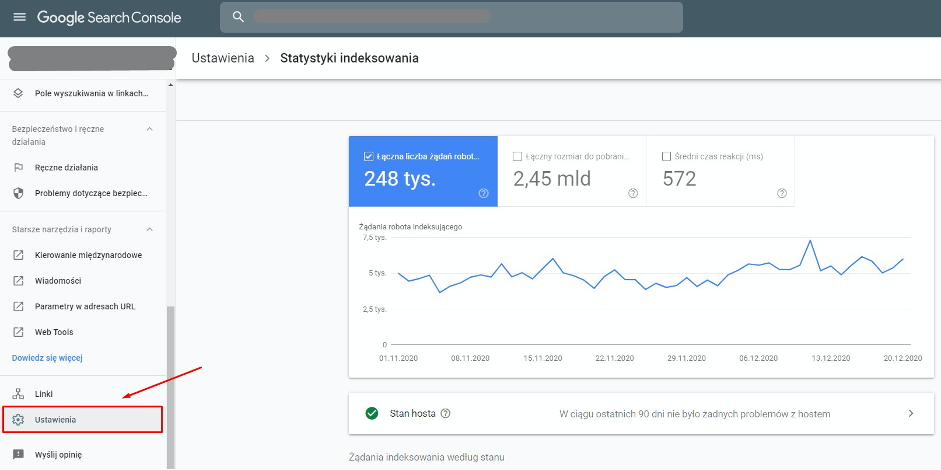

Możemy takie informacje weryfikować w Google Search Console. W ostatnim czasie Google wprowadziło w nowej wersji GSC narzędzie “statystyki indeksowania”, które ukryte jest w zakładce “Ustawienia”.

Narzędzie pod adresem: https://

Nieprzypadkowo użyłem określenia ukryte, ponieważ wcześniej było widoczne bezpośrednio z głównego menu i kierowało do starej wersji narzędzia dla webmasterów. Podobnie jak w poprzedniej wersji narzędzia - mamy możliwość analizowania:

- łącznej liczby żądań robota,

- łącznego rozmiaru plików pobranych podczas indeksowania,

- średniego czasu reakcji strony.

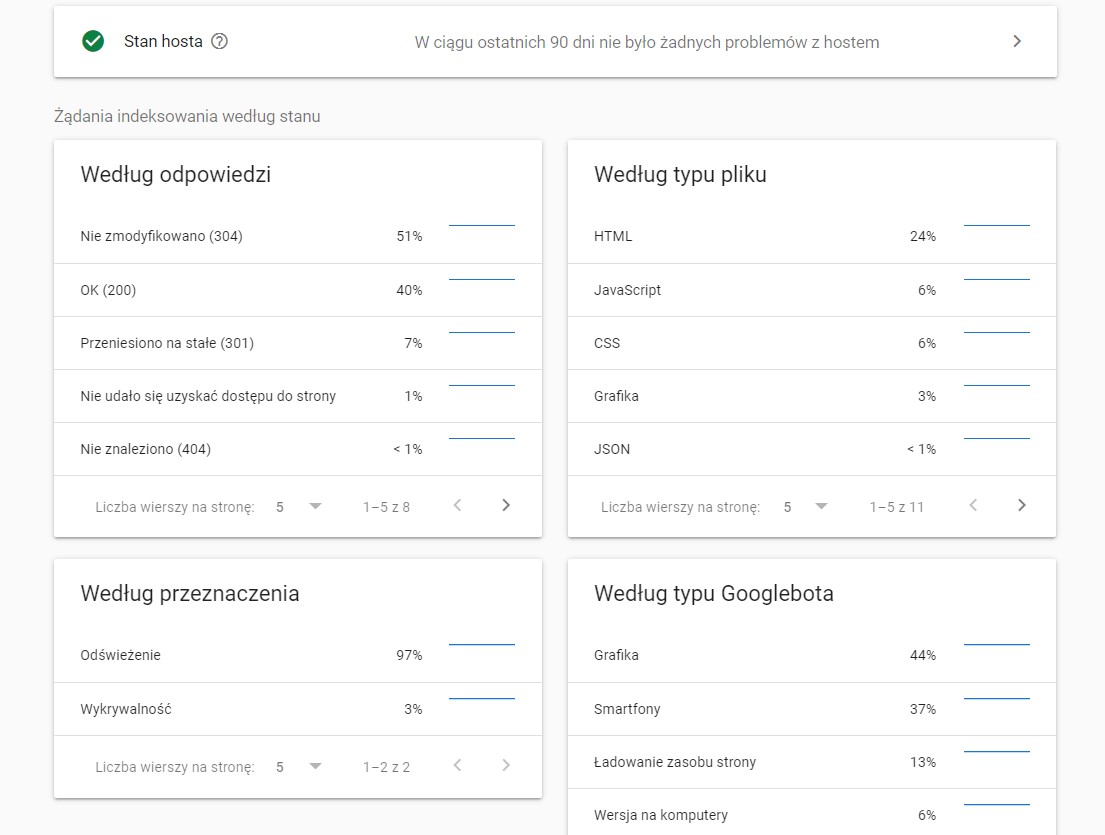

Warto - przy okazji omawianie crawl budget’u - wspomnieć o dodatkowych danych, których nie było w poprzedniej odsłonie statystyk indeksowania. Mowa tu o stanie hosta oraz podziale żądań indeksowania ze względu na typ.

Narzędzie pod adresem: https://

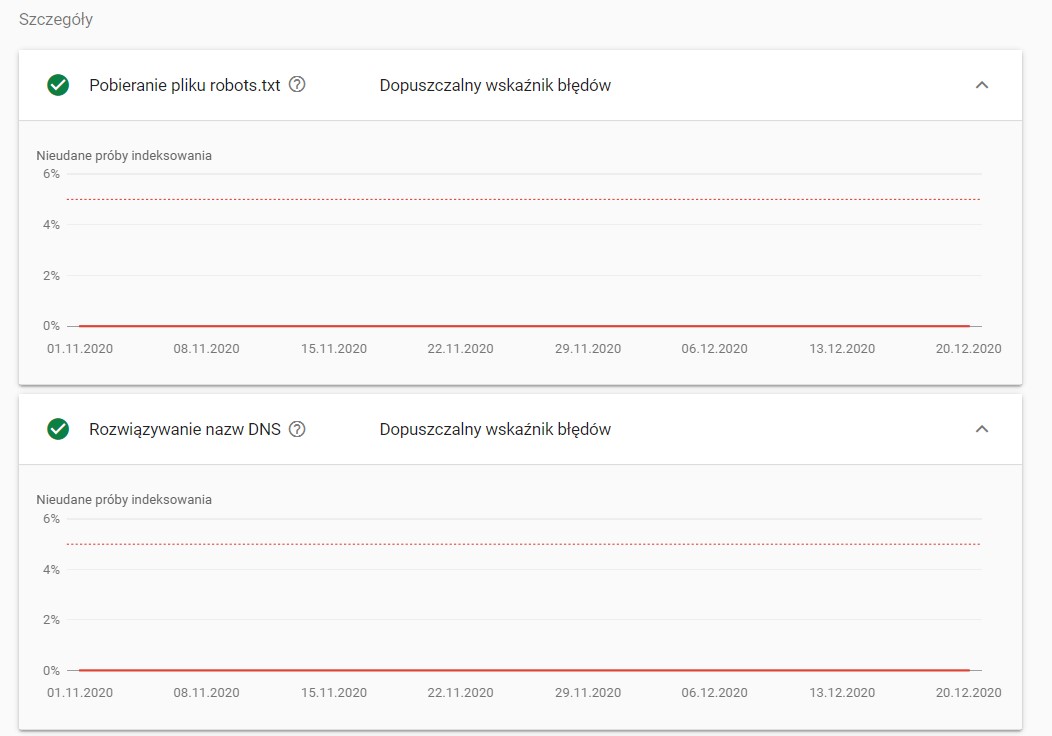

Podczas analizowania stanu hosta, możemy zweryfikować archiwalną dostępność pliku robots.txt, prawidłowe działanie serwerów DNS oraz procentową ilość problemów z łącznością z serwerem.

Stan hosta w narzędziu https://

Crawl demand, czyli popyt na indeksację

Drugim parametrem na podstawie którego Google przypisuje Crawl Budget jest tzw. “popyt na indeksację”. Czym on jest? W dużym skrócie możemy uznać, że Google na jego podstawie ocenia, czy strona “jest warta” częstego odwiedzania. Nawet gdy strona posiada jeszcze crawl rate limit, Google nie musi go wykorzystywać, gdy uzna, że nie ma większej wartości dla użytkownika. W jaki sposób Google ocenia w/

Popularność to w znacznej mierze częstotliwość pojawiania się linków do strony. Im więcej innych serwisów nawiązuje poprzez link do naszych treści, tym zyskują one na wartości w oczach Google. Bardzo często zauważam problem z indeksowaniem podstron przy dużych serwisach, które dopiero startują w internecie. Mają one często miliony podstron, które nie trafiają do indeksu. Dzieje się to właśnie z powodu zerowej popularności.

Świeżość serwisu to nic innego, jak częstotliwość zmian na stronie www. Im częściej pojawiają się nowe podstrony czy też aktualizują obecne, tym chętniej Google Bot odwiedza serwis internetowy. Jest to dość proste i logiczne, że chętnie odwiedzane są serwisy, które się zmieniają oraz często generują nowe treści.

Dlaczego Crawl Budget jest ważny dla SEO strony?

Częstym argumentem właścicieli stron za tym, by nie wdrażać wytycznych związanych z Crawl Budget’em, jest brak bezpośredniego wpływu na pozycję konkretnej frazy. Często pada pytanie - po co wydawać na wdrożenie, skoro to nie przełoży się na poprawę mojej pozycji na konkretne frazy? Aby zrozumieć wartość dodaną dbania o crawl budget, należy spojrzeć na widoczność serwisu globalnie. SEO to nie jest tylko praca nad kilkoma frazami - szczególnie w przypadku większych serwisów.

Wyobraźmy sobie, że otwieramy wielki e-commerce i nie myślimy o jego budowie w kontekście odpowiedniego dbania o Crawl Budget Google. Posiadamy tysiące produktów, które nie są indeksowane przez Google. Jaki jest tego efekt? Nie docierają do nich użytkownicy z wyników wyszukiwania, a my nie zarabiamy. Na nic zdadzą się godziny poświęcone na dokładne opisywanie kart produktów, ich optymalizacja itd. Google tego nie uwzględni, ponieważ nie ma szans na zaindeksowanie.

Jakie czynniki wpływają na budżet indeksowania Google?

No dobra, ciągle mówimy o tym, dlaczego warto dbać o crawl budget, a nadal nie wiadomo na czym to polega. Warto w tym momencie wymienić elementy strony, które są niczym kłoda rzucana pod nogi Google Bota, który wciąż stara się indeksować jak najwięcej podstron. To o czym będę teraz wspominał, powinno być elementem każdego audytu SEO - szczególnie, jeśli analizujemy średnie oraz duże serwisy www.

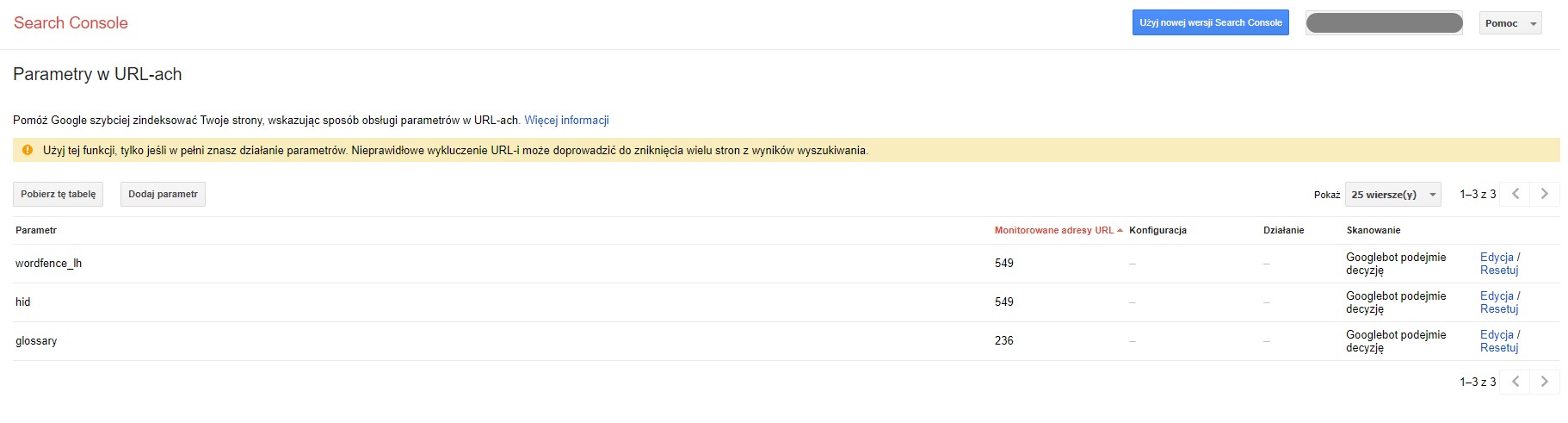

Parametry w adresach URL

Google w swojej dokumentacji potwierdza, że radzi sobie z parametryzacją adresów URL ale zwraca również uwagę, że adresy z parametrami często są źródłem powielenia treści. Właśnie w tym kontekście należy zwracać uwagę na blokowanie takich adresów oraz możliwość ustawienia interpretacji parametrów w Google Search Console - więcej na ten temat pod adresem: https://

Narzędzie ustawień paramteryzacji w Google Search Console: https://

Duplikacja treści wewnątrz serwisu

Kolejnym ważnym problemem, który ogranicza nasz crawl budget jest występowanie duplikacji treści. Często wynika ona z budowy serwisu. W e-commerce nieraz występuje z uwagi na filtrowanie produktów, które są źródłem nowych adresów URL. Mamy często ten sam opis kategorii oraz taki sam listing produktów dla wielu adresów z różnymi filtrami wyboru. Wystarczy, że produkty mają dość uniwersalne zastosowanie i po wyborze dowolnego filtru otrzymamy zbliżone wyniki. Google uzna wtedy, że nasze podstrony sklepu nie mają dużej wartości dla użytkownika i - z powodu duplikacji - zmniejszony zostanie nasz crawl budget.

Błędy 404 w linkowaniu wewnętrznym

Rotacja podstron czy produktów (w kontekście e-commerce) i występowanie adresów URL z kodem odpowiedzi 404 jest naturalnym następstwem działania serwisu. Ważne, by do takich usuniętych adresów (lub adresów z błędnymi znakami) nie kierować Google Bota. Dlatego też należy dbać o aktualizację linków wewnętrznych oraz sitemapy. Zarówno w jednym, jak i drugim miejscu nie powinny pojawiać się odnośniki do nieistniejących już adresów. Dlaczego? Google wraz ze wzrostem miejsc o statusie 404, dochodzi do wniosku, że wartość dla użytkownika maleje. Skoro internauci co chwila będą docierali do błędnych lub nieaktualnych adresów, nie znajdą nic wartościowego. Właśnie z tego powodu Google będzie oszczędzać swoje zasoby, rzadziej i krócej odwiedzając nasz serwis.

Pozorne błędy 404 zamiast standardowego kodu 404

Tak jak wspomniałem wcześniej, obecność adresów 404 jest naturalna i tak właśnie powinny być oznaczane usunięte lub niepoprawne adresy URL. Część serwisów po wpisaniu błędnego adresu, wyświetla kod odpowiedzi 200 z informacją o braku adresu w bazie danych. Jest to ogromny problem, ponieważ Google dostrzega odpowiedź z kodem 200 i poświęca swoje zasoby, by taki adres zaindeksować. Warto zweryfikować w Google Search Console informacje o stanie zaindeksowania i sprawdzić, czy nasz serwis nie generuje takich pozornych błęów 404. Można to zrobić pod adresem: https://

Indeksowanie tego, co ma wartość w SEO

Google na każdym kroku zwraca uwagę, że nie musimy indeksować wszystkich adresów URL serwisu. Co więcej, często rekomenduje, by ograniczać indeksowanie podstron, które powielają treści, linkowanie wewnętrzne lub nie mają dużej wartości w kontekście wyników wyszukiwania. Warto pamiętać, że nie wystarczy ustawienie tagu robots noindex, ponieważ Google i tak poświęci czas na próbę zaindeksowania takiego adresu. Dużo lepszym sposobem jest generowanie wielu czynności (takie jak np.filtrowanie) wewnątrz niezmiennego adresu URL lub blokowanie adresów będących wynikiem firtrowania w Robots.txt.

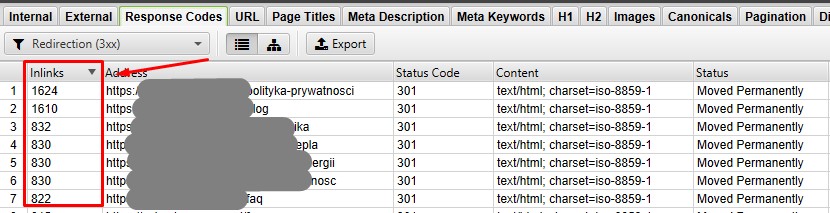

Łańcuchy przekierowań

Podczas crawlowania serwisu internetowego Google Bot ma określoną ilość kroków. Tak, wspominaliśmy już o tym… Dlaczego do tego wracamy? Musimy tutaj wspomnieć, że podczas wędrówki po stronach www Google często natrafia na adresy przekierowane. Każde takie wykonanie 301 czy 302, to zmarnowany krok. Szczególnie ważne jest to w sytuacji, gdy mamy do czynienia z przekierowywanymi adresami w linkach tzw. site-wide.

Analiza przekierowań w narzędziu Screaming Frog

Często spotykam się ze stronami, które w nawigacji (zarówno w górnym menu, jak i w stopce) posiadają linki do adresów bez “/

Aktualizacja i odpowiednia budowa Sitemap.xml

Dobrą praktyką jest umieszczanie w sitemap.xml adresów, które chcemy indeksować w wynikach wyszukiwania… Teraz zejdźmy na ziemię i omówmy, jak wygląda większość sitemap stron www? Znajduje się tam często wszystko, co jest elementem serwisu. Czasami nawet tysiące podstron będących wypełnieniem wersji demo motywu graficznego, które DEV powinien po uruchomieniu strony usunąć z bazy. Podczas optymalizacji stron często blokujemy indeksowanie takich elementów, jak np.:

- tagi

- filtrowanie

- sortowanie

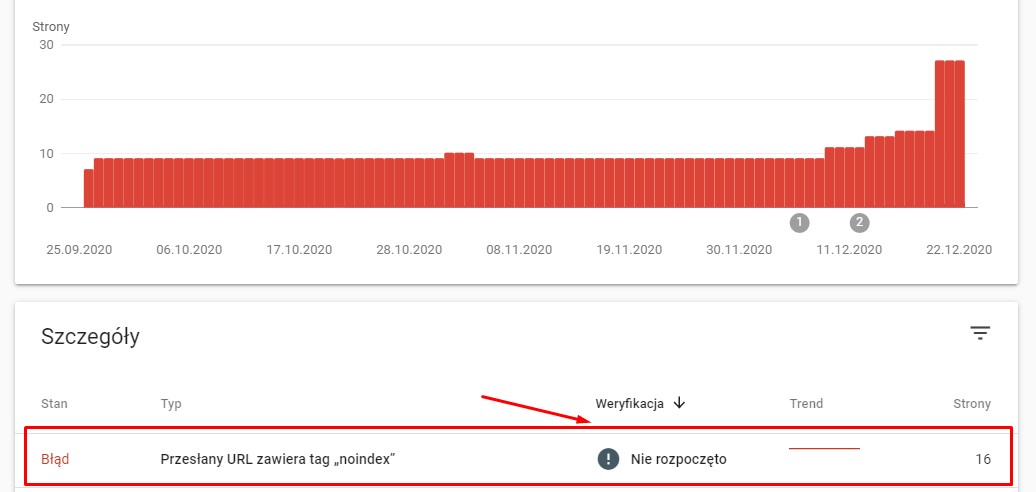

Decyzja ta bardzo często jest słuszna, ale warto pamiętać o tym, że to nie koniec. Należy wszelkie takie adresy usunąć z generowanej sitemapy. Unikniemy wtedy takich komunikatów w Google Search Console:

Analiza błędów indeksowania w Google Search Console

Szybkość strony

Zanim zaczniemy analizować wpływ szybkości na stronę, warto wspomnieć, że nie chodzi o ilości punktów oceny w wielu narzędziach, a realny czas oczekiwania na odpowiedź serwera, wczytanie się głównej treści strony itd.

Aby zoptymalizować ważne elementy, które wpływają na w/

Podsumowanie

Mam nadzieję, że po przeczytaniu tego artykułu w głowie zostanie pewna myśl - bez indeksacji nie ma ruchu z wyników wyszukiwania, a bez ruchu stronie nie zarabia.

Jeśli Twoja strona posiada problemy z indeksacją, to jest to ostatni dzwonek, by zająć się elementami o których wspominałem i maksymalnie ułatwić robotom Google indeksacje serwisu. Optymalizacja Crawl Budgetu nie jest wymysłem specjalistów SEO, a ważnym elementem, który potrafi skutecznie zwiększyć widoczność stron w wynikach wyszukiwania - szczególnie przy dużych serwisach oraz sklepach internetowych. Warto podejść do tego, jako szansy na większy ruch, a nie problematycznego wdrożenia rzeczy, które nie są czynnikiem rankingowym dla konkretnych fraz.

Senior SEO specjalista w agencji Digone